Nuovi panopticon nell’era dei Big Data

di Datamark e Daniele Gambit

“Facebook ha collezionato il più vasto insieme di dati mai assemblato sul comportamento sociale umano. Alcune delle tue informazioni personali ne fanno probabilmente parte.” — MIT Technology Review, 13 Giugno 2012

Un’espropriazione si compie ogni giorno in tutto il Mondo, nei luoghi pubblici, nelle strade, negli spazi dell’intimità personale, costituendo una — nuova — accumulazione originaria, centro nevralgico di nuovi processi di capitalizzazione. È l’espropriazione dell’informazione. Istituzioni, companies, centri di ricerca privati, analisti di marketing, polizia, intelligence, tutti si sono buttati in una caccia al tesoro diffusa e onnipresente, elaborando mezzi di analisi, inventando nuove fonti: a volte collaborando tra loro, a volte dichiarandosi guerra (o fingendo di farsela, come è successo tra Apple, Microsoft e US durante lo scandalo Datagate).

Un’espropriazione si compie ogni giorno in tutto il Mondo, nei luoghi pubblici, nelle strade, negli spazi dell’intimità personale, costituendo una — nuova — accumulazione originaria, centro nevralgico di nuovi processi di capitalizzazione. È l’espropriazione dell’informazione. Istituzioni, companies, centri di ricerca privati, analisti di marketing, polizia, intelligence, tutti si sono buttati in una caccia al tesoro diffusa e onnipresente, elaborando mezzi di analisi, inventando nuove fonti: a volte collaborando tra loro, a volte dichiarandosi guerra (o fingendo di farsela, come è successo tra Apple, Microsoft e US durante lo scandalo Datagate).

Mai come ora, nella storia dell’umanità, si è disposto di una quantità così grande di informazioni su fenomeni e comportamenti sociali, sia nel macroscopico — andamenti finanziari, scelte aziendali, valute — che nel microscopico — interessi personali, spostamenti di individui, informazioni biografiche-, con tutto quello che può comportare dal punto di vista del controllo sociale per le istituzioni di potere e l’analisi (e il controllo) dei desideri per il mercato.

La quantità di dati raccolti, esponenziale nel tempo, ha portato alla necessità di coniare un termine specifico — Big Data — per indicare questa mole di informazioni.

Se fino ad ora, con piccole quantità di dati, un esperto o un gruppo di ricerca poteva avvalersi di macchine e algoritmi classici per l’analisi e l’estrapolazione di informazioni utili, i Big Data rendono inefficienti e quindi obsoleti i vecchi metodi, mettendoci nella condizione, mai avuta prima, di possedere una quantità di dati maggiore di quella che i mezzi più accessibili ci permettono di gestire.

Oltre a questo, l’eterogeneità dei dati a disposizione permette di ottenere informazioni e previsioni in qualunque ambito sociale, aprendo la strada del possibile a scenari fino ad ora considerati fantascientifici.

La polizia di Los Angeles sta implementando un programma, PredPol, che grazie all’analisi di dati online dovrebbe riuscire a prevedere i futuri crimini, come nella dickiana Precrimine di Minority Report. Non si contano poi i casi di analisi e re-indirizzamento dei gusti personali degli utenti, con applicazioni nel mondo del marketing che tutti quotidianamente conosciamo (e con un effetto di censura ingannevole, quello della filter bubble).

“La diffusione di Big Data sta trasformando il modo in cui viviamo e lavoriamo, oltre a cambiare i rapporti tra governo, cittadini, imprese e consumatori”; o almeno così pensa la commissione che, il 1 Maggio 2014, ha presentato un rapporto ad Obama sui Big Data volto a “mostrare come i settori pubblico e privato possano massimizzarne i benefici minimizzandone i rischi”. Tra i benefici elencati dal report si parla di incrementare l’attività economica: non stupirà che si citi proprio Taylor e il suo “The Principles of Scientific Management” come esempio di spinta “all’efficienza della nazione”.

Si riconosce però il rischio che attraverso i Big Data e gli algoritmi a sorgente chiusa si possano evadere una serie di diritti civili fondamentali tra i quali le normative per la tutela delle categorie protette: casa, credito, impiego, salute ed educazione. Basti pensare, ad esempio, alle analisi che può mettersi a fare un proprietario immobiliare o una banca su un cliente per negargli eventualmente un contratto o un prestito sulla base di informazioni personali. La missione degli States, a detta di John Podesta, è “di assicurarsi che la rivoluzione digitale continui a occuparsi del potenziamento dell’individuo e del benessere sociale. Propriamente implementati, i Big Data diventeranno una direttrice storica di progresso.”

Ma in che senso i Big Data possono costituire un rischio per i diritti civili? Servirebbe un libro, o forse più di uno per dare una panoramica esaustiva sull’argomento. La preoccupazione principale è quella delle asimmetrie di potere che si vengono a creare: ad esempio Isabelle Carbonell ha mostrato come l’introduzione dello smart farming, ovvero la raccolta e l’uso di big data da parte di grandi agribusiness come Monsanto, rafforzi il potere di queste sul singolo agricoltore, che viene deprivato dei dati che produce come stipulato nei termini di uso della loro tecnologia. Un altro esempio concreto è stato dato, all’interno dello stesso progetto di ricerca, riguardo ai rischi della diffusione della education technology.

Attraverso learning analytics ed educational data mining, in alcune scuole americane sono stati introdotti algoritmi in grado di identificare studenti “a rischio”, istituzionalizzando lo sbilanciamento di potere tra studenti che si trovano senza possibilità di scegliere di rinunciare al servizio, e che si espongono al rischio di essere discriminati o stigmatizzati sulla base di dati raccolti e analizzati in maniera arbitraria e soggettiva da aziende private.

Data brokers o data management platforms (DMP) come quelle promosse da Palantir, Acxiom e piu’ o meno altre 4000 imprese, offrono servizi di ogni genere: ad esempio la prima si rivolge ad imprese, privati e istituzioni garantendo strumenti per analisi la cui applicazione va dall’ambito sanitario a quello assicurativo o finanziario. Fondata da Peter Thiel — già cofondatore di Paypal, primo investitore di Facebook e membro del transition team di Donald Trump — l’azienda si è impegnata in piu’ di un progetto con il governo americano negli ultimi anni. Palantir vende due prodotti, Gotham e Metropolis.

Sul loro sito si legge: “il nostro software è costruito per risolvere i più difficili ed incasinati problemi di Big Data, che tendono ad avere le seguenti caratteristiche: 1. I dati provengono da molte fonti differenti, 2. I dati sono incompleti od incoerenti oppure 3. Stai cercando qualcuno o qualcosa che non vuole essere trovato, e riesce ad adattarsi per evitare il tracciamento.”

La loro piattaforma è basata sui i sistemi di fraud detection di Paypal, e ha una partnership con il dipartimento della difesa statunitense.

Tra le tante definizioni usate per indicare i Big Data, è interessante soffermarsi su quella citata da Lev Manovich. “Big Data è un termine applicato a insiemi di dati la cui dimensione va oltre la capacità degli strumenti usati comunemente per raccogliere, gestire e processare i dati in lasso di tempo tollerabile.”.Questa definizione permette di fare chiarezza su una nuova forma di digital divide, dove il fatto che si richiedano strumenti “industriali” per conservare ed analizzare i dati produce tre nuove classi: quella di chi produce i dati (sia coscientemente che lasciando tracce digitali), quella di chi ha i mezzi per raccoglierli, e quella di chi ha mezzi e conoscenze per analizzarli.

In questo scenario di opportunità speculativa e deregolamentazione dilagante, le compagnie si immaginano coinvolte in una “corsa all’oro”: la metafora del data mining richiama l’idea che i dati siano una materia prima da cui è possibile estrarre un valore: è questa la mission di Google, Facebook e dei sempre più numerosi data broker. I dati di per sè non valgono niente, se non si ha la capacita’ di analizzarli. Ma riappropriarsi dei dati, eventualmente tramite formati aperti — open data — non basta: dobbiamo riprenderci anche i mezzi, e dunque la tecnica. Ma non solo: dobbiamo garantire un uso corretto dei dati, che vada oltre la loro semplice disponibilita’.

“Nessuno libera nessuno, nessuno si libera da solo, gli uomini si liberano nella mediazione con il mondo” — Paulo Freire

Davanti ad uno scenario di questo tipo, lo spaesamento è immediato. Non solo per la difficoltà tecnica nel provare a comprendere e analizzare le attuali dinamiche di controllo distribuito, ma anche e soprattutto per il senso di impotenza e incapacità di azione politica contro un potere che si è fatto sovranazionale e distante dalla vita quotidiana. Le possibili reazioni successive sono molteplici. Una tentazione è la demonizzazione del dispositivo tecnologico in sé, considerando lo strumento specifico intrinsecamente oppressivo, in quanto oggi svolge per lo più questa funzione. E’ un istinto che tende alla difesa personale, di cui abbiamo certamente bisogno, soprattutto nel momento di dover comunicare informazioni sensibili, e sulla quale si dovrebbe sempre più fare autoformazione (crittazione mail, sistemi di messaggistica cifrati…) ma che rischia di non portare a chiedersi come capovolgere, come hackerare, il dispositivo di controllo.

Dall’altra parte, se accompagnato da retoriche legalitarie e moralismi, il timore del panopticon può portare all’emergere di un elogio della trasparenza individuale, dell’accondiscendenza al controllo come virtu’ del buon cittadino. E’ il caso del “non aver nulla da nascondere”, del “controllateci tutti”, dove spesso questa tolleranza è considerata moneta di scambio imprescindibile nella richiesta di trasparenza da parte di istituzioni e organi statali. Un primo passo per provare a fare chiarezza è rivendicare l’asimmetria di potere tra le parti coinvolte, asimmetria che fa la distinzione tra un controllo invadente e un monitoraggio popolare delle istituzioni.

Il punto di appoggio più forte su cui un governo può fare leva nel giustificare la propria pervasività, lo sappiamo, è il tema della sicurezza. La privacy individuale — che comunque meriterebbe una parentesi per quanto riguarda le critiche provenienti dall’ambiente femminista — è messa al bando in nome della sicurezza di tutti, e nel discorso comune la trasparenza si fa virtù.

Nei casi poi di cyberspionaggio, che sia un paper diffuso su Wikileaks o — seppur molto differente — un caso come quello dei fratelli Occhionero, per difendere la necessità di trasparenza individuale il potere deve ricorrere all’allarmismo collettivo, dichiarando che la fuga di dati sensibili non sono un pericolo tanto per le istituzioni — che ovviamente “non hanno nulla da nascondere” — bensì un pericolo per la sicurezza nazionale.

Nel discorso dominante non vi è riscontro del rapporto di forza, che invece attribuisce un senso diverso dell’atto di osservazione qualora sia effettuato dal carcerato o dal carceriere, differenza che suggerisce di provare ad immaginare la tecnologia come mezzo di controsorveglianza, di evasione dal carcere.

A questo punto una precisazione è doverosa: avviare questo tema e provare a suggerire un’analisi politica non è stato facile, e di certo non abbiamo raggiunto una conclusione. Vorremo anzi lanciare queste provocazioni come inizio di un possibile e proficuo dibattito, che coinvolga e faccia interloquire realtà politiche con progetti che da anni lavorano negli ambiti telematici e delle tecnologie. Ed è proprio riguardo le nuove possibilità di mediattivismo, che crediamo sia possibile provare a sviluppare strumenti utili nel contrasto delle narrazioni tossiche dominanti e nella conduzione di indagini sociali utili alla collettività.

Vi sono stati vari esempi, in questo ultimo decennio, di progetti interessanti da analizzare per studiare le possibilità di sovvertimento della macchina panoptica. Già ben prima dell’avvento dei social network e dei Big Data, il progetto veneziano di Anopticon ha mostrato un utilizzo virtuoso e liberante di contro-mappatura, costruendo un’indagine sulle telecamere di videosorveglianza distribuite sul territorio urbano di molte città italiane. “Grande Fratello, ti stiamo osservando!” recita lo slogan del progetto. In tempi più recenti gli esempi si sono moltiplicati. Ad esempio Bellingcat è una piattaforma di Open Source Intelligence (OSINT) che, attraverso forme investigative open source in base ai dati raccolti social media costruisce inchieste sociali, report dai territori colpiti da conflitti in medio oriente o indagini su casi corruzione. Bellingcat raccoglie contributi in forma aperta, e sviluppa guide con l’obiettivo di diffondere e rendere accessibili le pratiche di OSINT.

Tutti conosciamo ormai Wikileaks, organizzazione internazionale che riceve e pubblica in modo anonimo contenuti di interesse politico e sociale, spesso coperti da segreto. Esistono altri software di whistleblowing anonimo, come l’italiano GlobaLeaks, nato nel 2010, dal quale poi sono nati progetti di interesse locale come Aquileakes, per far emergere abusi e speculazioni nella ricostruzione post-terremoto dell’Aquila. A livello internazionale troviamo Syrian Archive, piattaforma realizzata da giornalisti e associazioni per raccogliere materiale e prove sulle violazioni dei diritti umani nel conflitto siriano, o il recente Data4Democracy, database di materiale condiviso sviluppatosi nei movimenti anti-Trump.

In quello che è noto come crowdmapping — la costruzione condivisa, decentrata e libera di mappe interattive che si fanno strumenti di comunicazione di un messaggio — si fa interagire un dato spaziale, geolocalizzato, con una serie di dati di carattere temporale. Un caso italiano è la mappa di #Renziscappa, che ci ricorda quante volte l’ex-premier se l’è data a gambe davanti le contestazioni.

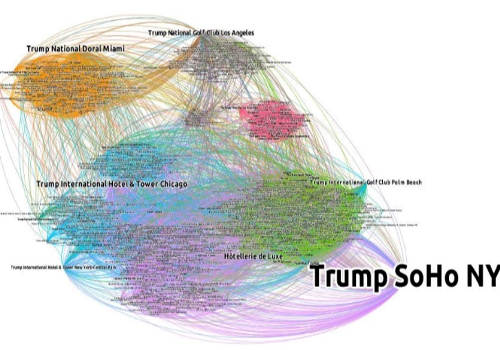

Golf, edilizia e hotel di lusso: la rete sociale facebook di Donald Trump

Vi è in questo caso un potenziale utilizzo di una grossa mole di dati e di metadati ad essi relativi con finalità ben differenti dall’esempio di Facebook, e tra i tratti distintivi in questo processo vi è ovviamente la decisionalità nella cessione dei dati, l’anonimato, e soprattutto la struttura della piattaforma su cui si interagisce: aperta, decentrata, ecc…

È possibile poi usare strumenti di data visualization per rappresentare grafi costruiti a partire dai dati ricavati dai social newtork, come nel caso di giornate di mobilitazione (#15M, #NonUnaDiMeno), o per studiare reti sociali a partire da Facebook e Twitter (siti complottisti, pagine neofasciste, relazioni sociali di un candidato alla Casa Bianca, etc…). Recentemente seguendo questi spunti è nato Teknopolitica, un laboratorio che prova a seguire sui social network i fatti rilevanti di cronaca politica (#assembleaPD) e le mobilitazioni (#NonUnaDiMeno) cercando di costruire pratiche di comunicazione.

Per quanto sia differente, anche il caso di Salvatore Iaconesi puo’ essere considerato una riappropriazione di dati.

Nel suo testo “La Cura”, Salvatore racconta come attraverso l’hacking e l’open-sourcing dei suoi referti medici abbia messo in atto una “performance partecipativa volta a ridefinire la parola ‘cura’, portandola fuori dagli ospedali”.

La parola Open Data si sta diffondendo tra ambienti eterogenei, quali gruppi di attivisti e governi locali o federali negli Stati Uniti e nel resto del mondo: se da una parte la Open Knowledge Foundation tedesca propone di sviluppare “empowering media” (allo stesso tempo pero’ facendo Lobbying per promuovere una licenza che permetta di usare tali dati a scopo di lucro) in grado di analizzare e presentare risultati a partire dalla base di dataset condivisi ed aperti, dall’altro una lettura anche solo superficiale della ricerca e delle proposte sull’Open Data del governo USA (che ha avuto ripercussioni in tutta gli stati della UE) rivela come per questi la questione sembri essere limitata all’accesso all’archivio, mentre partecipazione (che oltre ad essere indiretta è anche involontaria nella maggior parte dei casi), la costituzione ed interpretazione sono delegate a terzi.

Del resto basta vedere le conseguenze dell’apertura dei dati in Karnataka (India), dove pochi investitori si sono mobilitati subito dopo l’apertura dei dati (promossa come iniziativa per dar potere ai piu’ poveri) per acquistare ogni pezzo di terra ancora libero (e usato da contadini o altri residenti) che fossero in grado di identificare grazie ai dati geospaziali. In questo caso, invece di portare ad un “processo automatico di democratizzazione” l’apertura dei dati e’ servita piuttosto come forma di potere disciplinare. È vero che, come scrive Derrida, “Non esiste potere politico senza il controllo dell’archivio, o della memoria.

Un effettiva democratizzazione può sempre essere valutata da questo criterio essenziale: la partecipazione e l’accesso all’archivio, la sua costituzione e la sua interpretazione.” Ma non si puo’ certo ignorare che fintanto che l’attenzione si concentra unicamente sull’apertura, la disponibilita’, dei dati, il loro utilizzo rimarra’ arbitrario, speculativo, oppressivo.

Se i Big Data sono il nuovo propulsore dell’economia digitale, il nuovo motore di un progresso che non si puo’ fermare, gli Open Data rischiano di diventare una questione di libero mercato, di libera circolazione di capitale: il valore dei dati sta nella loro interpretazione, non in essi stessi. Non c’è arricchimento senza la possibilità di accedere a conoscenze ed hardware estremamente costoso o limitato (vedi Google Bigquery).

È anche vero che il valore dei dati sta nella loro interconnessione, nella capacita’ di poterli comparare, confrontare, unire. Un archivio globale di tutti i dati disponibili, aperto, resterebbe comunque sterile per chi non avesse i mezzi per processarlo, ma costituirebbe invece un enorme miniera d’oro per chi ha il possesso dei mezzi per estrarlo.

Si deve notare anche come la questione dei Big Data sia intimamente legata a questioni di legittimità: fiducia (trust) e fede (belief). Fiducia nell’oggettività dei social network che raccolgono i dati e li aggregano in enormi dataset, classificandoli. Fede nel governo che dovrebbe proteggerci da usi illeciti di questi dati. La struttura delle piattaforme stesse di raccolta dei dati costituisce lo stampo attraverso cui si analizza la società, analisi dalla quale si spera di poter definire politiche, aree di intervento e priorità. Ripetiamo ancora che non è solo la costituzione dell’archivio a dover tornare in mano ai cittadini: ancora più importante è l’accesso ai mezzi e alle conoscenze per analizzarlo. Ogni dataset puo’ essere interpretato in diversi modi, e il discorso dominante tende a omogenizzare le interpretazioni. Sopratutto se i mezzi e gli archivi sono proprietari, black-boxed ed in ogni caso estremamente costosi o ad accesso limitato (premium).

Una tecnologia in sè non è mai buona o cattiva, ma nemmeno è neutrale. Considerato il potenziale dei Big Data per rafforzare certe posizioni ideologico-discorsive, crediamo che sia arrivato il momento di considerare come si possa fare uso dei dataset disponibili per iniziare un opera di decostruzione di alcune di queste. Ricordando sempre che non bisogna cedere a facili entusiasmi, ad esempio per il fatto che i dati saranno sempre più circolanti e sempre più trasparenti, ma che invece c’è bisogno di mobilitarsi per costruire mezzi che permettano analisi dal basso, e indagare insieme su cosa possiamo fare con queste.

I Big Data promettono anche di aiutare a difendere le minoranze, a creare una società più equa. Invece di cedere alla paranoia e chiudersi in una fuga individuale dietro la crittografia, forse è possibile collaborare per fare in modo che questa tecnologia (e gli effetti che potrebbe avere sulla società) non sia uno strumento in mano – unicamente – ai governi, alla polizia, alle mafie, ai grandi imprenditori, alle lobby.

Provando a lanciare un impressione che sia di esempio per un’analisi liberante di dati (ma è solo una delle tante possibili) abbiamo pensato al potenziale di ibridazione di percorsi di lotta che può portare l’hackmeeting di quest’anno, che si terrà in estate — date da definire — in un paese della Valsusa. E’ possibile usare l’analisi di dati come mezzo di indagine, argomentazione, potenziamento discorsivo delle lotte territoriali? Che strumenti possono nascere dall’intersezione dei progetti telematici di mediattivismo con i movimenti sociali, nell’era dei Big Data?

Rompere le catene digitali che ci legano e liberare la ricchezza che già generiamo è dunque tra gli obbiettivi più importanti delle lotte d’oggi. Se spaventa il grado di controllo e di estrazione della ricchezza che si cela dietro questo nuovo panorama deve confortare e dar forza l’idea che altrettanto grandi ed influenti possono essere i risultati delle lotte che si insinuano in tale piano. Una pratica di sabotaggio immaginata per falsare il dato o bloccarne la cessione, facilmente riproducibile e diffondibile, può generare impatti economici enormi per chi ci espropria di questi stessi dati. Reinventare e diffondere pratiche di sciopero e sabotaggio nel processo di estrazione-espropriazione di tale ricchezza rappresenta un imperativo ed una sfida imprescindibile per chi, oggi come ieri, non vuole cedere a tale ricatto.